DoNews12月30日消息,腾讯混元今日宣布开源翻译模型 1.5 版本,共包含两个模型:Tencent-HY-MT1.5-1.8B 和 Tencent-HY-MT1.5-7B,支持 33 个语种互译以及 5 种民汉 / 方言,除了中文、英语、日语等常见语种,也包含捷克语、马拉地语、爱沙尼亚语、冰岛语等小语种。

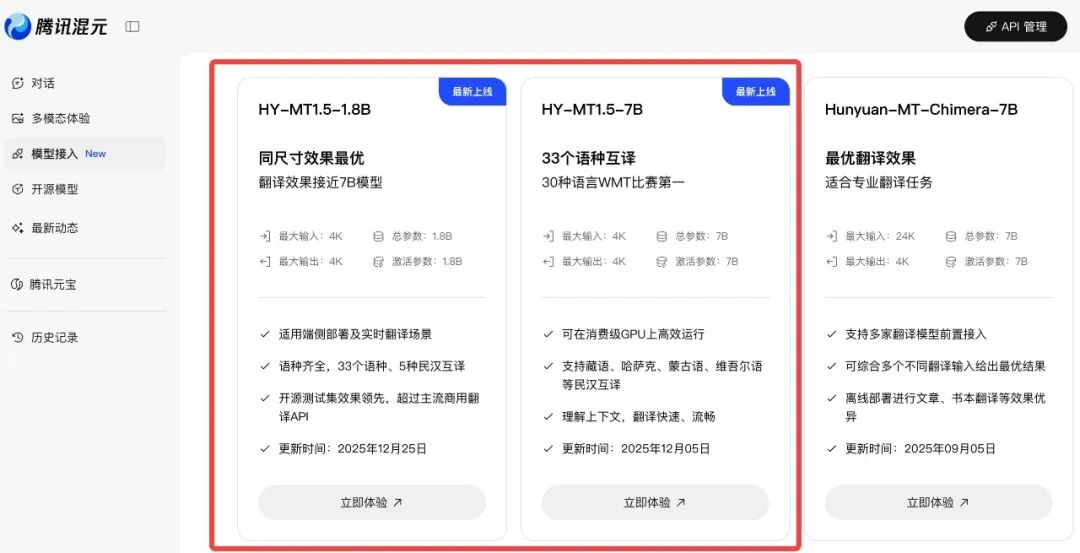

目前两个模型均已在腾讯混元官网上线,在 Github 和 Huggingface 等开源社区也可直接下载使用。

HY-MT1.5-1.8B 主要面向手机等消费级设备场景,经过量化,支持端侧直接部署和离线实时翻译,仅需 1GB 内存即可流畅运行,并且宣称在参数量极小的前提下,效果超过了大部分商用翻译 API。

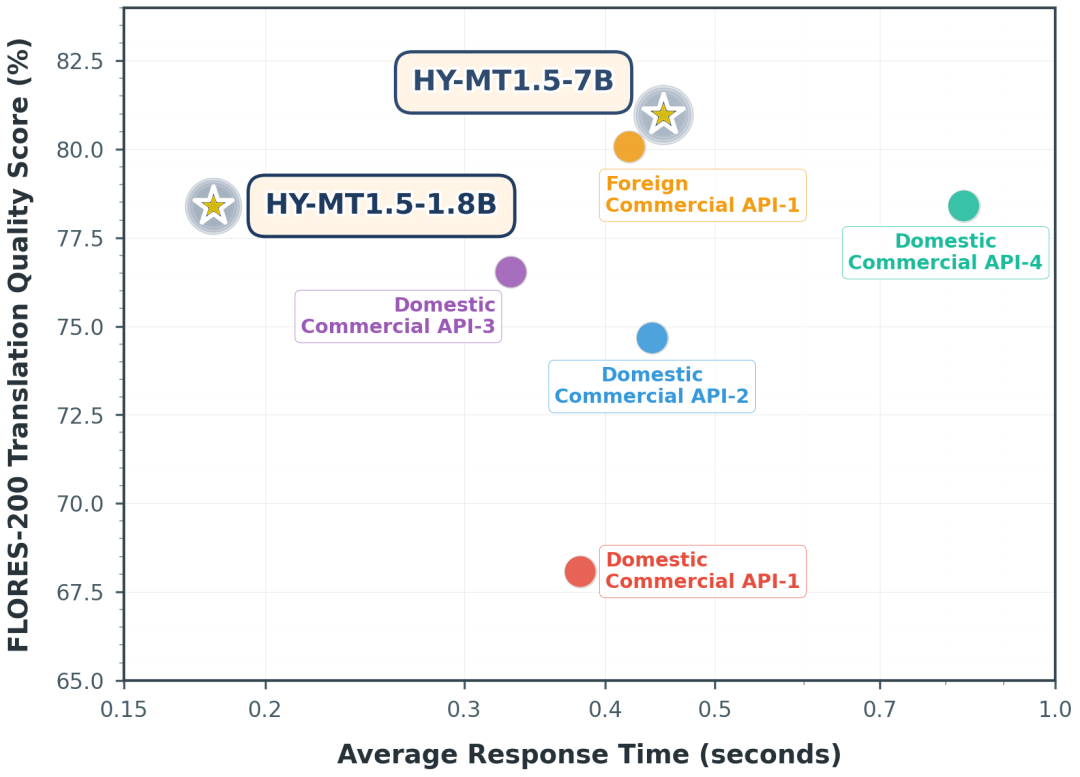

同时,与主流商用翻译模型 API 对比,HY-MT1.5-1.8B 推理速度更快,处理 50 个 tokens 的平均耗时只有 0.18 秒,其他模型的时间在 0.4 秒左右。

HY-MT1.5-7B 模型效果相比前一版本效果有较大提升,是此前获得 WMT25 比赛 30 个语种翻译冠军模型的升级版,重点提升了翻译准确率,大幅减少了译文中夹带注释和语种混杂的情况,实用性进一步增加。

在部分用户实际使用场景下,混元翻译 1.8B 和 7B 两个尺寸模型同时使用,可以实现端侧和云侧模型的协同部署,提升模型的效果的一致性和稳定性。

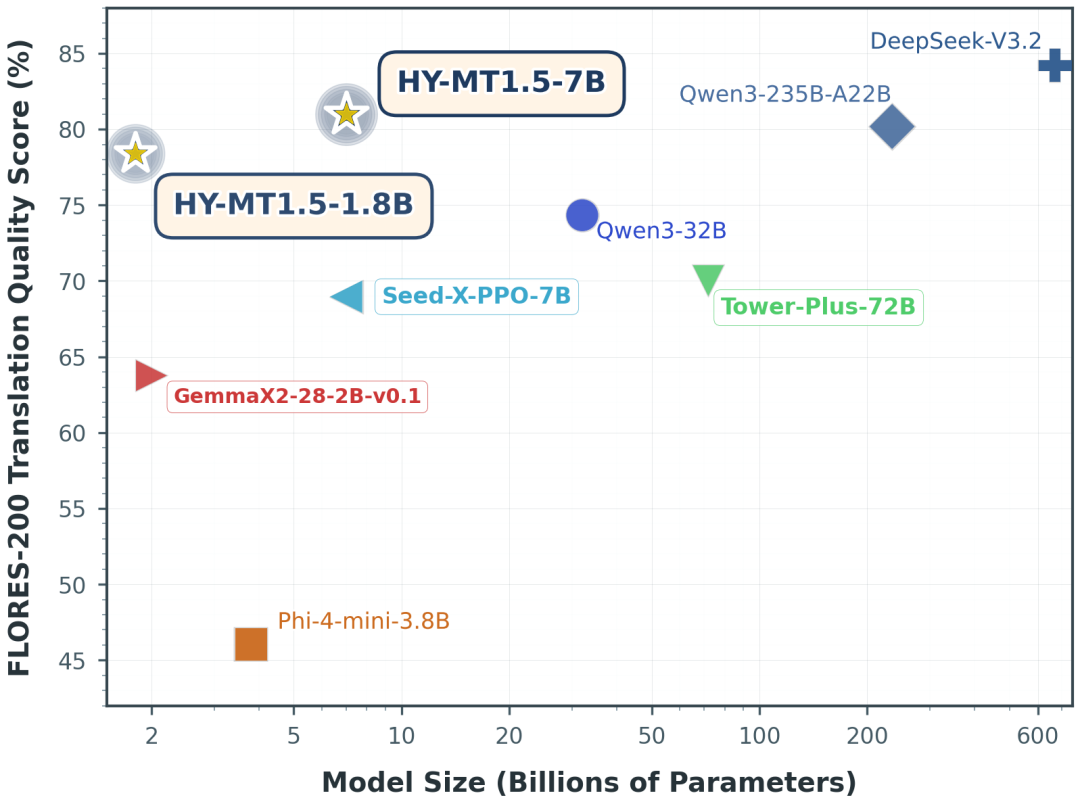

在常用的中外互译和英外互译测试集 Flores200、WMT25 以及民汉语言的测试集中,Tencent-HY-MT1.5-1.8B 全面超越中等尺寸开源模型和主流商用翻译 API,达到 Gemini-3.0-Pro 这种超大尺寸闭源模型的 90 分位水平。在 WMT25 和民汉翻译测试集上,其效果仅略微差于 Gemini-3.0-Pro,远超其他模型。

HY-MT1.5-1.8B 模型在 FLORES-200 质量评估中取得了约 78% 的分数,同时平均响应时间 0.18 秒,超越主流商用翻译 API,适用于即时通讯、智能客服、移动翻译应用等高吞吐、实时翻译场景。

此外,针对各类场景,两个模型均实现了对术语库、长对话、带格式文本(例如网页)的翻译支持,更加全面:

首先是术语,腾讯混元翻译模型 1.5 具备术语库自定义能力,用户可针对不同行业与专业场景(如医学、法律、金融、科技等)提前构建专属术语对照表,确保关键术语在翻译中保持高度一致与准确性。

用户可通过简单配置导入术语库,模型将在翻译过程中优先采纳用户定义的标准术语,从而提升专业文档、技术手册、合同文本等内容翻译的可靠性与权威性。

其次是上下文翻译。混元翻译模型具备长文本与对话上下文理解能力,可基于前文语境持续优化后续翻译结果,提升长对话、多轮问答、连续段落等场景下的翻译连贯性与一致性。

无论是会议记录、访谈内容、小说章节还是技术文档的长篇翻译,模型均能捕捉并保持上下文逻辑关系,避免出现指代不清、语义断裂或风格不统一的问题。

第三是带格式翻译能力,通过指令遵循能力,混元翻译模型得以保持翻译前后的格式信息不变,让翻译结果更加准确实用。

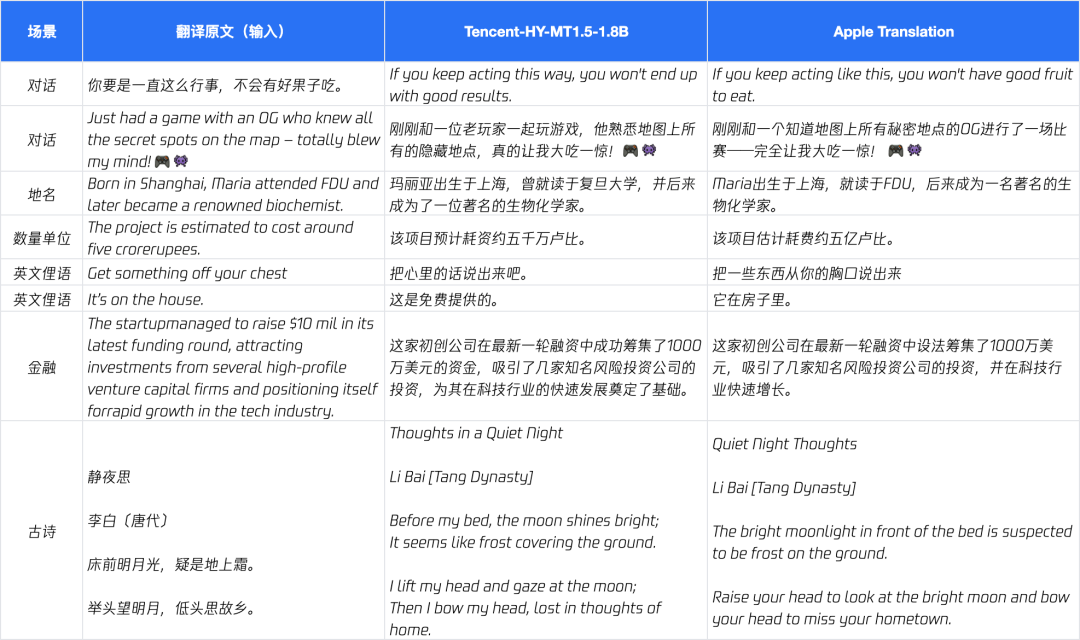

为了直观展示混元 Tencent-HY-MT1.5-1.8B 的翻译效果,官方展示了与苹果手机自带离线翻译的结果对比:

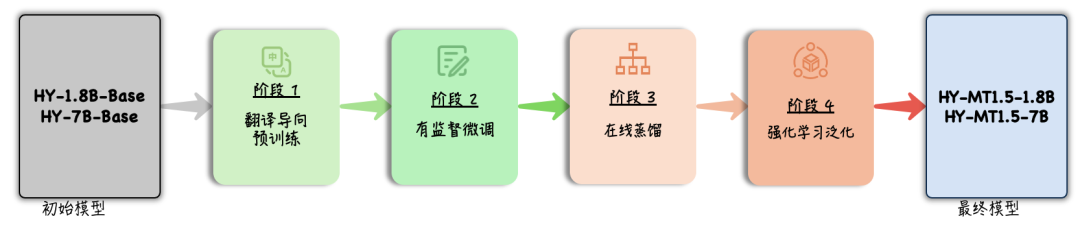

技术方面,HY-MT1.5-1.8B 能够用小尺寸实现大尺寸模型的效果,得益于 On-Policy Distillation(大尺寸模型蒸馏)策略的引入,让 HY-MT1.5-7B 作为 Teacher,实时引导 1.8B 的 Student 模型,让其避免死记硬背标准答案,通过纠正在预测序列分布时的偏移,让小模型从错误中学习,提升能力。

腾讯混元翻译模型此前不仅在国际机器翻译比赛拿下 30 个第 1 名,也在首次开源一周内便登上了 HuggingFace 模型趋势榜第一位。混元翻译模型已经在腾讯内部多个业务场景落地应用,包括腾讯会议、企业微信、QQ 浏览器、客服翻译等。

为了便于开发者使用,本次开源的模型已经在 Github 和 Huggingface 等开源社区上线,Arm、高通、Intel、沐曦等多个平台均支持部署。