DoNews1月27日消息,月之暗面今日宣布推出并开源了其最新的 Kimi K2.5 模型。同时,Kimi 智能助手 K2.5 版本正式上线。用户在官网聊天界面中原本的 K2 模型已自动切换为 K2.5 版本。

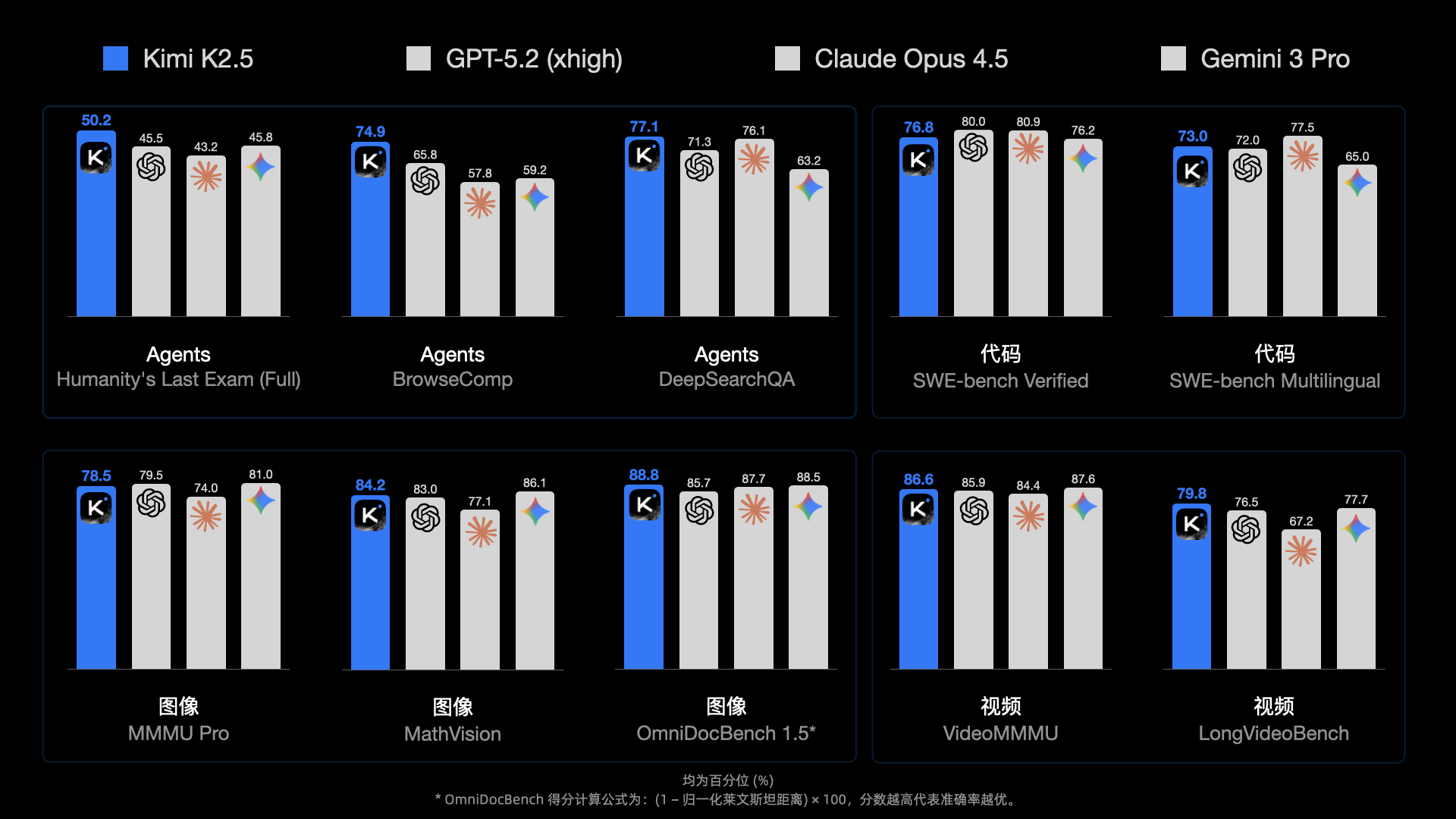

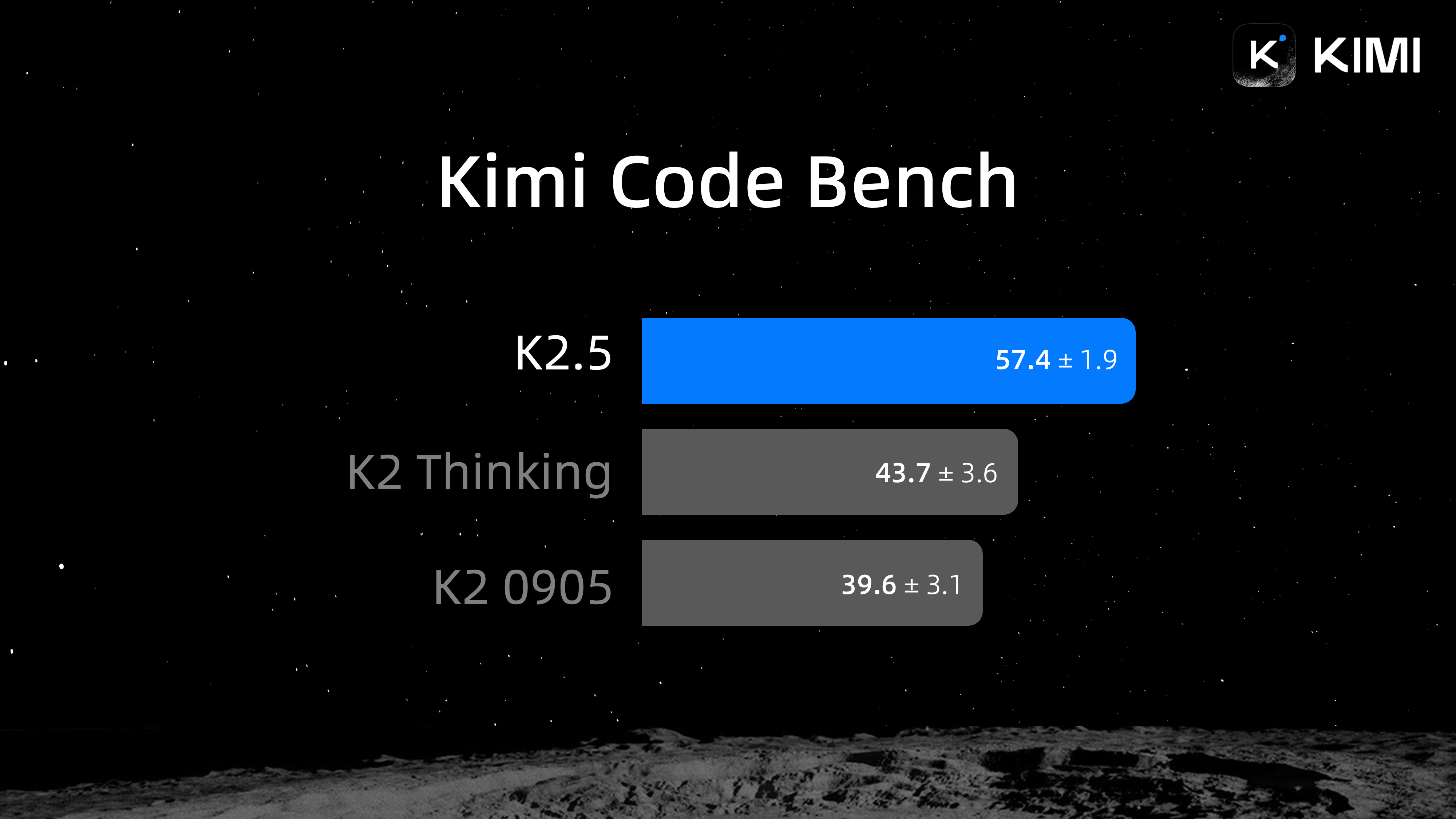

该模型是其目前最智能的模型,在 Agent、代码、图像、视频及一系列通用智能任务上取得开源 state-of-the-art 表现;同时也是 Kimi 迄今最全能的模型,采用了原生的多模态架构设计,同时支持视觉与文本输入、思考与非思考模式、对话与 Agent 任务。

在模型定位上,Kimi K2.5 被设计为一款通用型多模态模型,可在对话、复杂推理和自动化任务之间切换使用。

与此前版本相比,该模型在视觉理解与推理能力上进一步加强,用户在与模型交互时,不再局限于文字描述,还可以直接上传图片、截图或录屏内容,由模型进行分析和处理。这一能力被用于辅助理解界面操作、分析文档结构以及还原交互流程等场景。

在编程与软件工程方面,Kimi K2.5 延续了 K2 系列在代码生成领域的技术路线,尤其是前端开发方面,并支持通过截图或录屏视频来理解并复现代码逻辑。

官方示例显示,该模型可以基于自然语言指令生成完整的前端页面代码,并处理包含动态布局、滚动触发等在内的交互逻辑。同时,结合视觉能力,Kimi K2.5 可以对用户提供的界面录屏进行拆解,分析其背后的交互结构,并生成相应的实现代码。这一功能已在部分 API 内测用户的应用场景中得到验证,例如在视频动作识别与分析类产品中的使用。

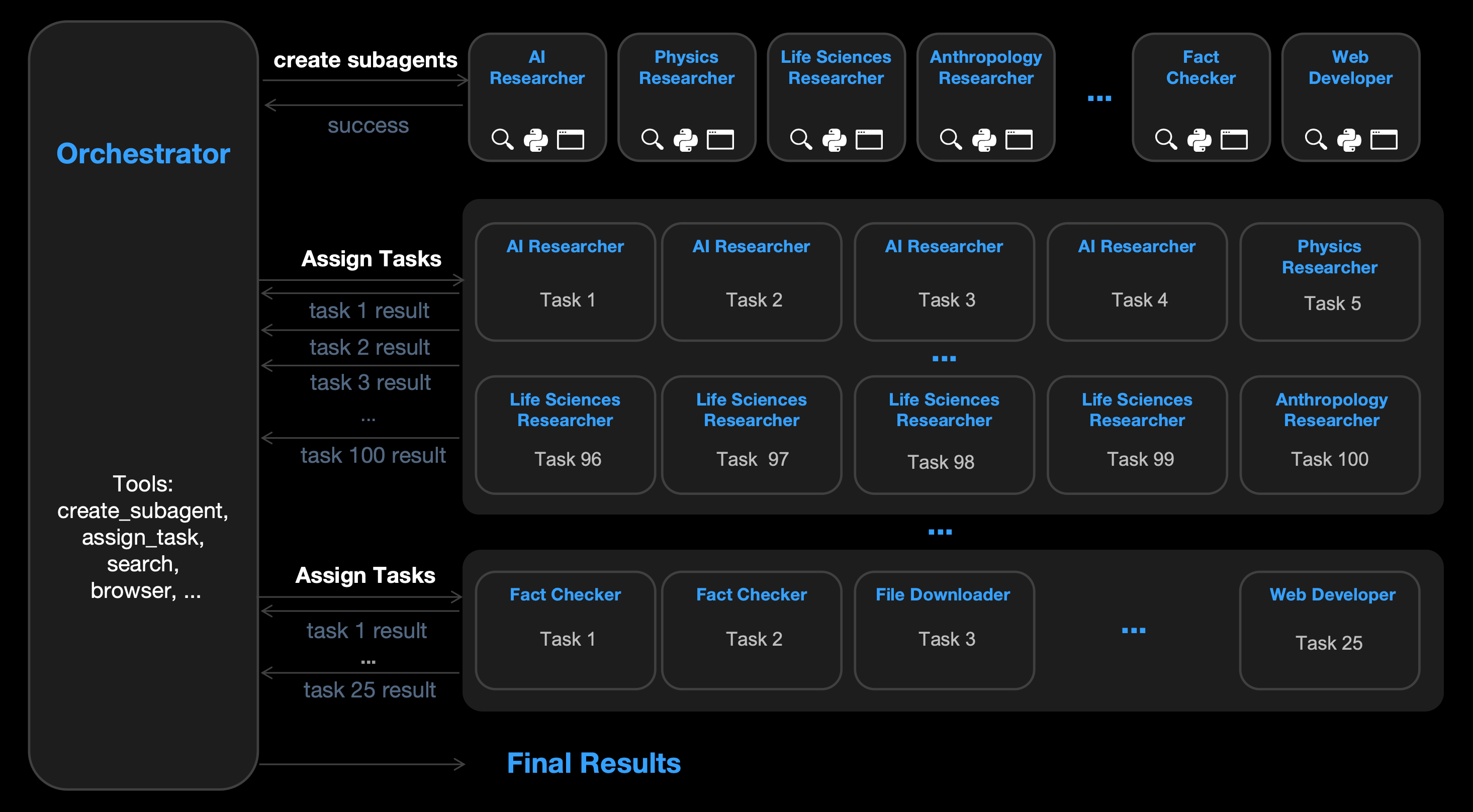

除单一 Agent 能力外,Kimi K2.5 引入了新的“Agent 集群”机制。这一机制允许模型在面对复杂任务时,不再以单一 Agent 形式执行,而是根据任务需求动态生成多个子 Agent,并行完成不同子任务。

官方介绍称,Agent 集群最多可调度上百个子 Agent,并支持上千步的任务执行流程,所有角色分工与任务拆解由模型在运行过程中自动完成,无需人工预设。在长文本处理与资料整合类任务中,Agent 集群已被用于多篇论文的通读、分工撰写与最终汇总,输出结构化的长篇文档。

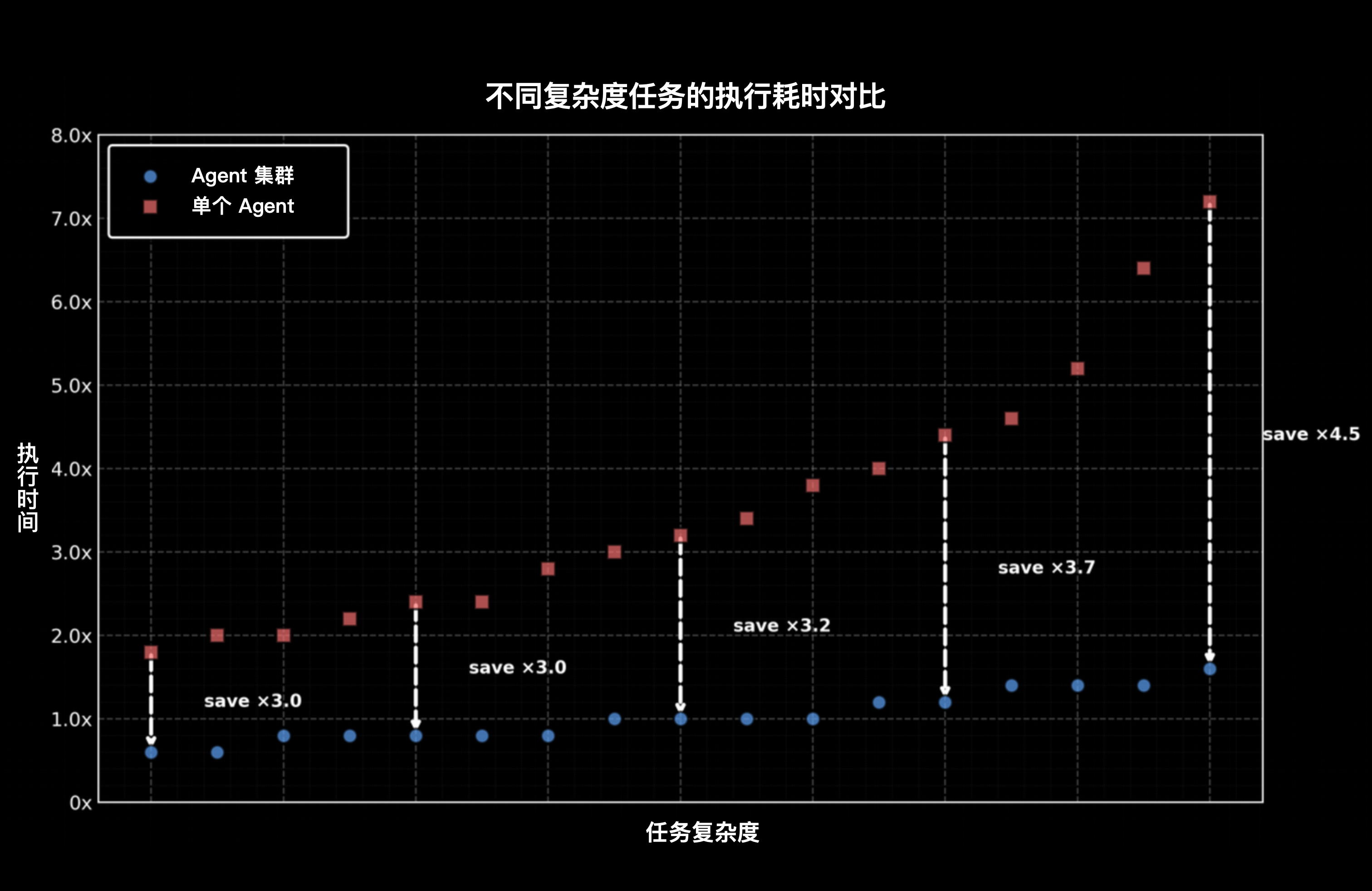

性能方面,在大规模搜索与复杂任务场景下,相比单 Agent 执行方式,Agent 集群在完成目标所需的关键步骤数量和整体执行时间上均有所减少。为支持这一能力,团队对强化学习训练基础设施和相关算法进行了重构,目前该功能仍处于 Beta 测试阶段,计划逐步向更多用户开放。

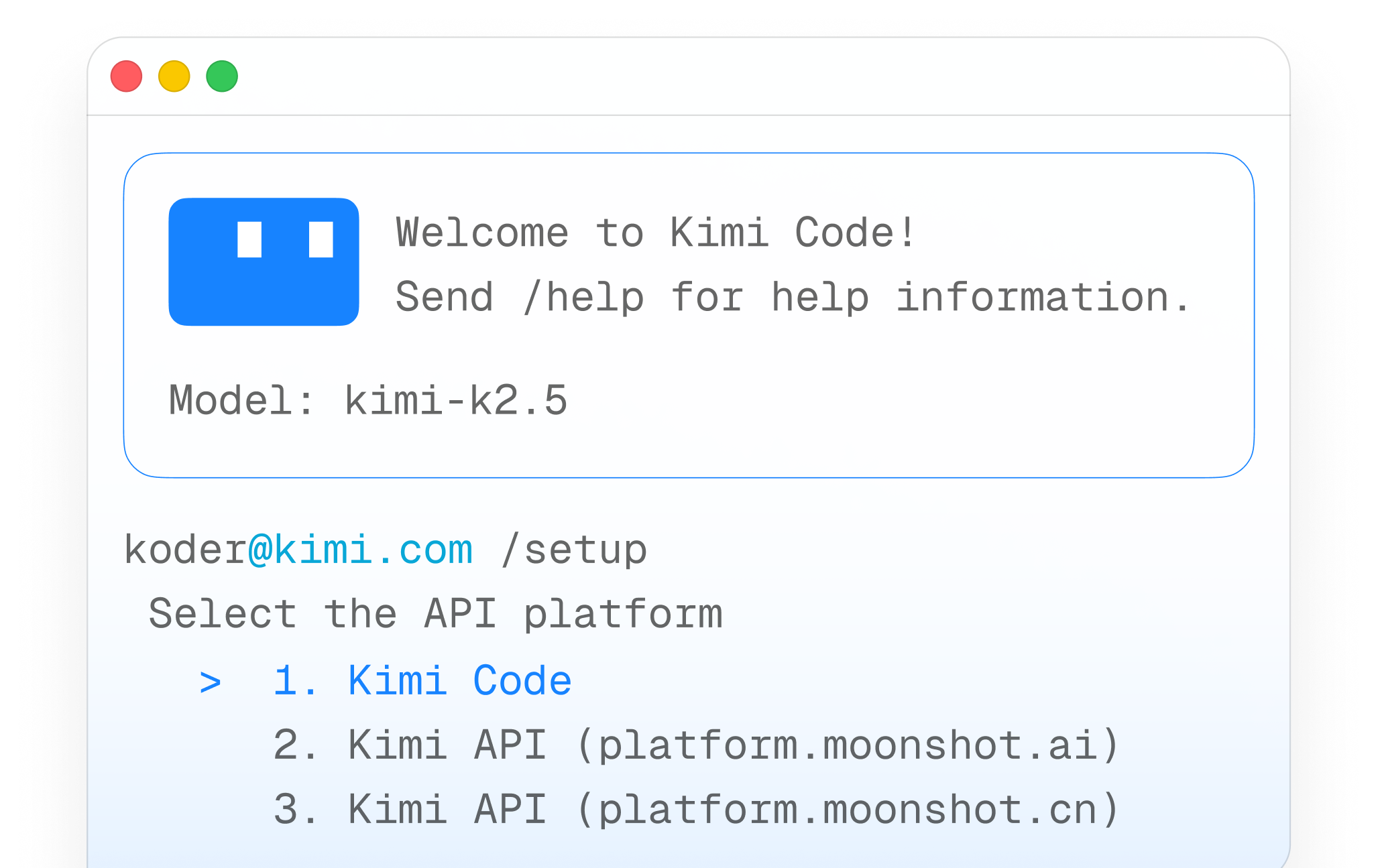

随 Kimi K2.5 模型一同发布的还有月之暗面面向开发者的编程工具 Kimi Code。该工具可在命令行环境中运行,并支持与 VS Code、Cursor、JetBrains 系列 IDE 以及 Zed 等主流编辑器集成。

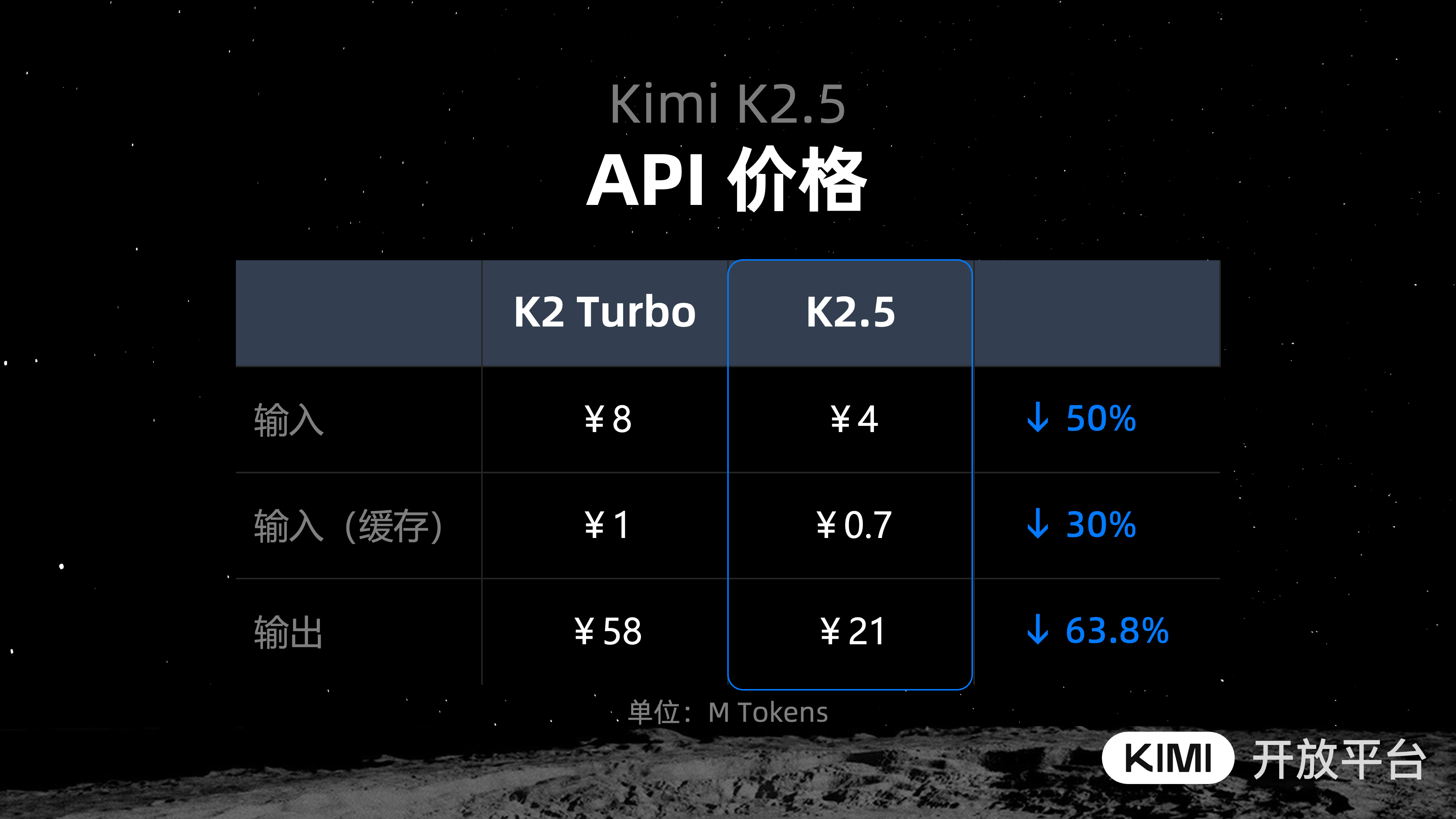

目前,Kimi K2.5 模型已在 Kimi 官方网站、移动 App 及其 API 开放平台上线。普通用户可通过不同模式使用其功能,开发者和企业也可通过 API 进行调用。