以ChatGPT为代表的语言类大模型改变内容生成方式,而多模态模型仍待突破。近日,智源研究院发布包括Emu3在内的“悟界”系列大模型,可实现文本、图像、视频的组合理解与生成。

尽管2024年大模型价格战激烈,2025年的应用呈现百花齐放态势,但部分核心技术仍处于发展阶段。例如,视频生成能力介于GPT-2到GPT-3之间,尚未达到产业预期。多模态模型需要更长时间的技术沉淀,这也为未来带来更多想象空间。

Emu3是智源2024年10月发布的多模态模型,目前正训练新版本。基于此模型,智源还推出全球首个脑科学多模态通用基础模型见微Brainμ。智源研究院院长王仲远表示,当前多模态模型通常先强化语言能力再学习其他模态信息,这种路径可能导致能力下降。

人类学习路径与此不同,从出生起即接触声音、图像等多模态信息,文字学习则较晚开始。因此,原生多模态模型在初始阶段即整合多种模态数据进行训练。然而,如何从复杂模态数据中筛选有效信息成为技术难题。

Sand.ai创始人曹越指出,视频生成领域虽有Sora等高质量模型,但DiT训练方案扩展性不足,类似早期BERT模型的局限性。智象未来创始人梅涛认为,视频生成处于GPT-2到GPT-3阶段,面临叙事性、稳定性和可控性三大挑战。

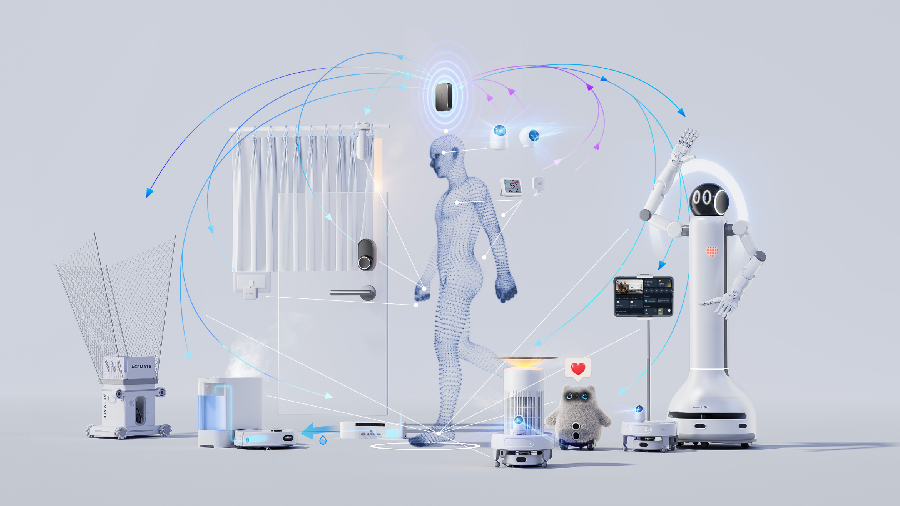

商业化方面,智谱AI CEO张鹏强调,大模型在视觉领域的落地需兼顾生成与理解两方面,目前技术融合尚存障碍。智象未来从2023年的PaaS服务,到2024年的SaaS工具,再到2025年的结果导向模式,逐步降低使用门槛。

根据中研普华产业研究院数据,2024年全球多模态AI市场规模达24亿美元,预计2025年将增长至1280亿美元,复合增长率高达62.3%。尽管存在诸多挑战,多模态大模型的未来发展潜力巨大。

免责声明:本文内容由开放的智能模型自动生成,仅供参考。