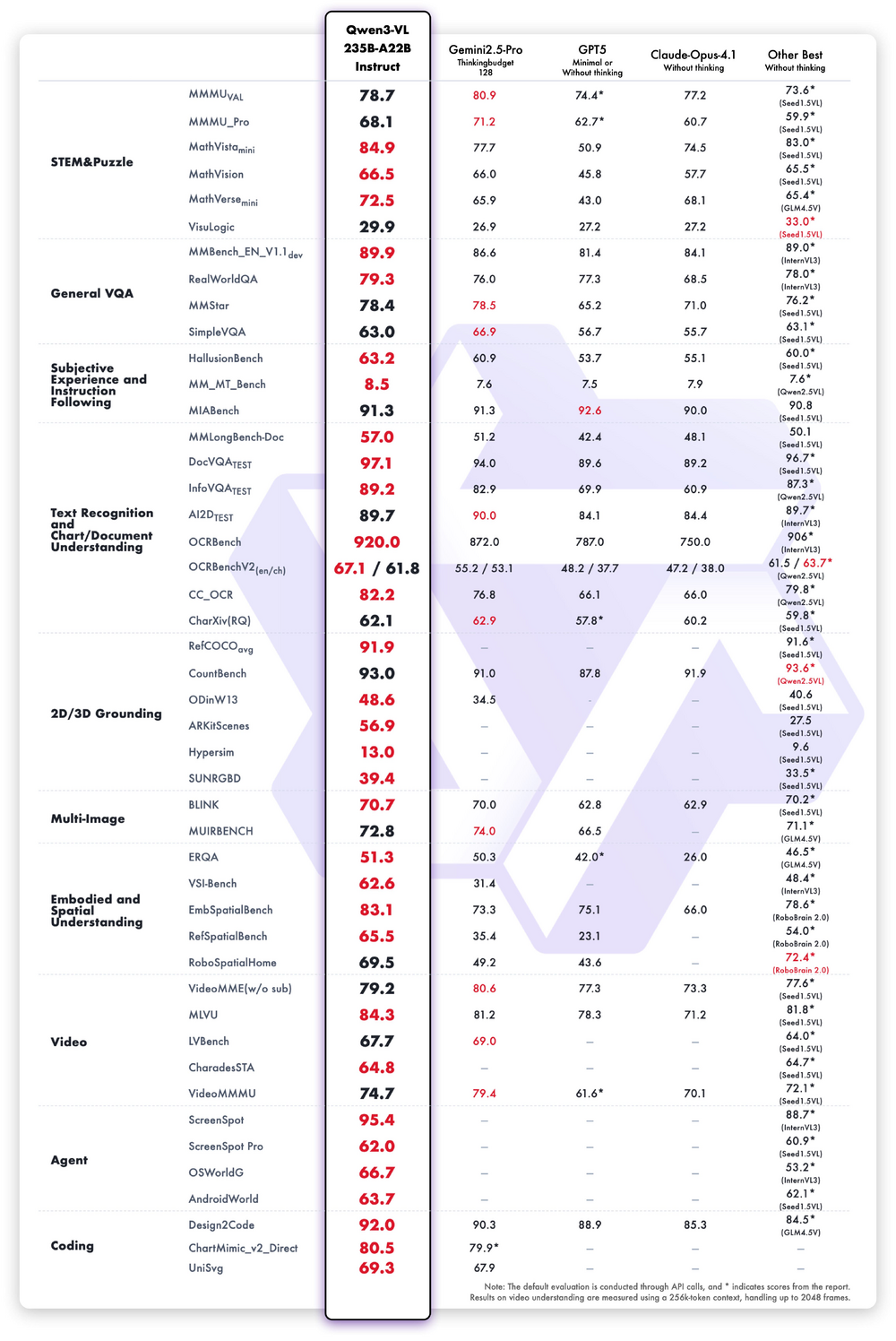

9月24日的2025云栖大会上,阿里开源新一代视觉理解模型Qwen3-VL。该模型在视觉感知和多模态推理方面实现重大突破,在32项核心能力测评中超过Gemini2.5-Pro和GPT-5。同时,Qwen3-VL大幅提升了视觉Agent、视觉编程和空间感知等关键能力,不但可调用抠图、搜索等工具完成“带图推理”,也可以凭借一张设计草图或一段小游戏视频直接“视觉编程”,“所见即所得”地复刻图表、网页和复杂程序。

【图说】:Qwen3-VL-235B-A22 Instruct测评分数

本次开源的是旗舰版Qwen3-VL-235B-A22B,有开源指令(Instruct)模型和推理(Thinking)模型两大版本。Qwen3-VL展现了在复杂视觉任务中的强大泛化能力与综合性能,在逻辑谜题、通用视觉问答、多语言文本识别与图表文档解析、二维与三维目标定位、具身与空间感知、视频理解等32项具体测评中,指令版Qwen3-VL超越了Gemini2.5-Pro 和 GPT5 等闭源模型,同时刷新了开源多模态模型的最佳成绩。推理版Qwen3-VL多模态思考能力显著增强,在 MathVision、MMMU、MathVista 等权威评测中达到领先水平。

Qwen3-VL拥有极强的视觉智能体和视觉Coding能力,几乎刷新所有相关评测的最佳性能。Qwen3-VL 不仅能看懂图片,还能像人一样操作手机和电脑,自动完成许多日常任务,例如打开应用、点击按钮、填写信息等,实现智能化的交互与自动化操作。输入一张图片,Qwen3-VL可自行调用Agent工具放大图片细节,通过更仔细的观察分析,推理出更好的答案;看到一张设计图,Qwen3-VL 就能生成Draw.io/HTML/CSS/JS 代码,“所见即所得”地完成视觉编程,真正推动大模型从“识别”迈向“推理与执行”。

Qwen3-VL可支持扩展百万tokens上下文,视频理解时长扩展到2小时以上。这意味着,无论是几百页的技术文档、整本教材,还是长达数小时的会议录像或教学视频,都能完整输入、全程记忆、精准检索。Qwen3-VL还能根据时间戳精确定位“什么时候发生了什么”,比如“第15分钟穿红衣服的人做了什么”、“球从哪个方向飞入画面”等,都能准确回答。

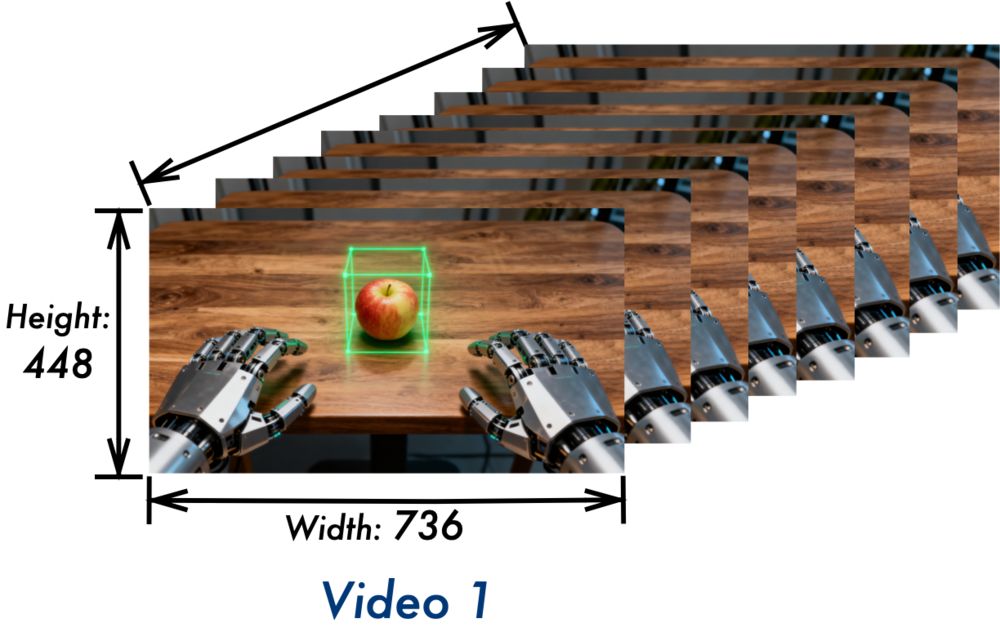

【图说】:Qwen3-VL的3D检测能力增强,未来可协助机器人等具身智能判断物体的方位。

大模型的空间理解能力是实现具身智能的基础,Qwen3-VL 专门增强了3D检测(grounding)能力,可以更好地感知空间。当前,机器人想要轻松抓住桌上的一个苹果,并不容易。凭借Qwen3-VL强大的3D检测能力,未来可让机器人更好地判断物体方位、视角变化和遮挡关系,从而准确判断苹果的位置与自身距离,实现精准抓取。

据了解,千问视觉理解模型已实现广泛落地,比如国家天文台联合阿里云发布的全球首个太阳大模型“金乌”,正是基于 Qwen-VL 等模型以超过 90 万张太阳卫星图像为样本完成微调训练。未来,Qwen3-VL模型还将开源更多尺寸版本。即日起,用户可在通义千问QwenChat上免费体验Qwen3-VL,也可通过阿里云百炼平台调用API服务。

Qwen3-Omni新闻稿

标题1:阿里开源全模态大模型Qwen3-Omni,可像人类一样听说写

标题2:阿里开源全模态大模型Qwen3-Omni,狂揽32项开源最佳表现

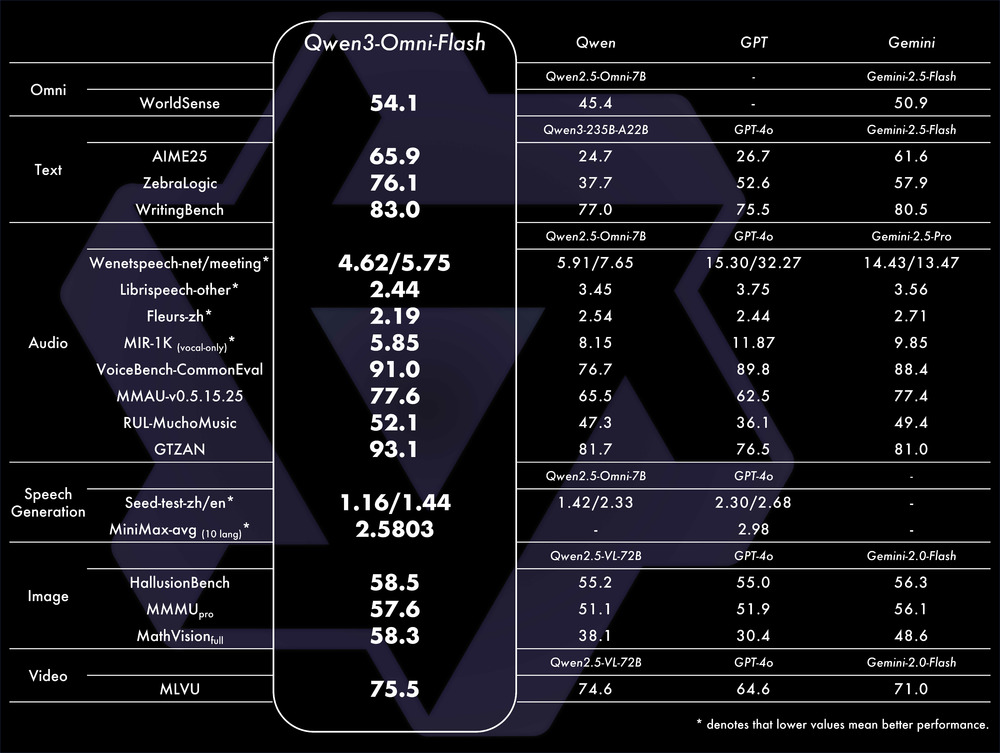

9月24日,2025年云栖大会开幕,阿里巴巴发布通义全模态预训练大模型Qwen3-Omni系列模型。通过引入多种架构升级和技术迭代,Qwen3-Omni系列的模型表现和效率大幅提升。在36个音视频基准测试中,22项达到SOTA水平,其中32项取得开源模型最佳效果。语音识别、音频理解与语音对话能力可比肩Gemini 2.5-Pro。

作为全模态模型,Qwen3-Omni能够实现全模态输入和全模态输出。类似于人类婴儿一出生就全方位感知世界,Qwen3-Omni一开始就加入了“听”、“说”、“写”多模态混合训练。在预训练过程中,Qwen3-Omni采用了混合单模态和跨模态数据。此前,模型在混合训练后,各个功能会相互掣肘甚至降智,比如音频理解能力提升,文字理解能力反而降低了。但Qwen3-Omni在实现强劲音频与音视频能力的同时,单模态文本与图像性能均保持稳定,这是业内首次实现这一训练效果。

Qwen3-Omni的优异表现源于多种架构升级。Qwen2.5-Omni采用了双核架构Thinker-Talker,让大模型拥有了人类的“大脑”和“发声器”。Qwen3-Omni的Thinker-Talker架构进一步加强,结合AuT预训练构建强通用表征,配合多码本设计,响应延迟压缩至最低。相较于半年前推出的Qwen2.5-Omni,Qwen3-Omni的交互速度更快,纯模型端到端音频对话延迟低至211ms,视频对话延迟低至507ms;支持的语言更多,包括19种语言音频输入、10种语言输出。

作为一款“会说话”的模型,Qwen3-Omni应用场景广泛,未来可部署于车载、智能眼镜和手机等。用户还可设定个性化角色、调整对话风格,打造专属的个人IP。相较于传统的录音转文字软件,Qwen3-Omni能够处理长达 30 分钟的音频文件,无需切割音频,即可精准识别语音、深度理解内容。

目前,Qwen3-Omni系列已开源三款模型:Qwen3-Omni-30B-A3B-Instruct、Qwen3-Omni-30B-A3B-Thinking 和 Qwen3-Omni-30B-A3B-Captioner,值得关注的是,擅长音频描述的模型Qwen3-Omni-30B-A3B-Captioner为全球首次开源的通用音频caption模型,可以清晰描述用户输入音频的特征,填补了开源社区空白。

Qwen3-Omni现已在Hugging Face和ModelScope上开放,用户可访问Qwen Chat免费体验Qwen3-Omni-Flash。

【图说】:Qwen3-Omni测评分数